Vous désirez intégrer la liste de diffusion ? Un mail à ssphub-contact@insee.fr suffit

La fin de l’année est généralement synonyme de bétisiers, best of ou rétrospectives personnalisées qui nous permettent de nous rappeler les événements marquants de l’année.

Pour célébrer la fin de l’année 2022, la newsletter de janvier adopte un format un peu spécial pour proposer, en deux temps, deux rétrospectives.

Cette première newsletter revient sur les principaux événements de l’année 2022 dans le monde de la data science. La seconde newsletter proposera une rétrospective quantitative sur le réseau des data scientists de la statistique publique, à la manière des rétrospectives personnalisées de nos applications préférées.

Les IA créatrices de contenu à l’honneur

Si l’année 2022 a été particulièrement riche dans le domaine de la data science, c’est principalement grâce à deux coups médiatiques d’OpenAI, à savoir Dall-E et ChatGPT.

Ces deux outils ont beaucoup fait parler d’eux, au-delà de la sphère traditionnelle de la data science. Le buzz a été intense sur Twitter ou sur Mastodon, le réseau social dont le nombre d’utilisateurs a nettement augmenté en réaction au rachat de Twitter par Elon Musk en fin d’année.

Ces innovations, parce qu’elles pourraient avoir des effets à long terme sur la manière dont le grand public appréhende l’intelligence artificielle, ont beaucoup intéressé les médias traditionnels, notamment Le Monde, The Economist et sa “Nouvelle Frontière” ou le Guardian qui s’interroge sur la nature des tâches que l’intelligence artificielle pourra remplacer à terme : procédurales et régies par des règles bien définies ou bien également des activités nécessitant de la créativité et des capacités d’analyse ?

Pour une fois, il ne s’agit donc pas de souligner exclusivement les limites de ces modèles voire leurs dérives (deep fake, biais racistes…) mais aussi de s’enthousiasmer sur leur potentiel créatif. Il est difficile de rester insensible à certaines des créations artistiques des modèles Dall-E, Stable Diffusion, Midjourney et consorts ou de résister à la tentation de tester la capacité de ChatGPT à répondre à des questions complexes Les chercheurs, et pas des moindres (notamment Andrew Ng ou Gaël Varoquaux) se sont également saisis de cette question et ont souligné les biais de raisonnement et excès de confiance de ces IA.

Si vous désirez utiliser Python de manière créative pour générer du contenu avec Stable Diffusion, vous pouvez consulter ce tutoriel qui fonctionne sur le SSPCloud ou sur Google Colab.

Le succès des modèles de diffusion

Ces IA génératrices de contenu reposent toutes, à plusieurs niveaux, sur des réseaux de neurone.

Le premier étage de la fusée est un modèle de langage (large language model) qui synthétise un langage en un ensemble complexe de paramètres. Les plus connus sont BERT et GPT-3. L’inflation dans le nombre de paramètres n’est pas prête de s’arrêter. Si les ressources nécessaires à entraîner en 2018 le modèle BERT (110 millions de paramètres) avaient déjà été critiquées en raison de leur coût financier et environnemental, cette complexité a encore augmenté depuis. Le modèle GPT-3, sorti en 2020, et qui sert de base à Dall-E et ChatGPT intègre 175 milliards de paramètres. Un chiffre qui apparaît minime par rapport aux 17O trillions de paramètres attendus pour le modèle GPT-4 en 2023.

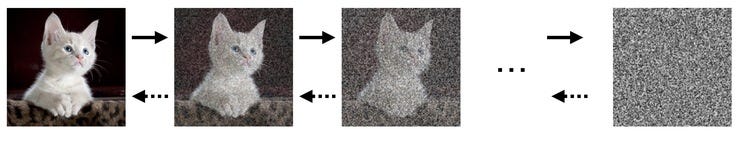

En ce qui concerne les IA créatrices de contenu visuel, le deuxième étage de la fusée est un modèle d’analyse d’image qui apprend à associer des images à une description textuelle afin de détecter des structures communes entre des mots ou des séquences de mots et des formes sur des images. Il s’agit de déconstruire une forme en une structure minimale de pixels qui permet de l’identifier.

Ensuite, pour générer une image à partir d’une description inédite intervient le modèle de diffusion qui reconstruit une image à partir du mélange de l’ensemble des pixels qui traduisent les concepts principaux d’une instruction. L’une des explications les plus pédagogiques pour comprendre le fonctionnement de ces modèles vient du Washington Post.

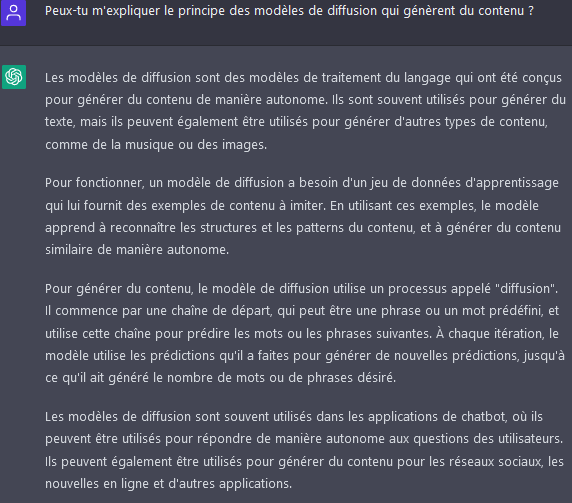

Sinon, on peut demander directement à ChatGPT de nous expliquer:

L’actualité dans le monde du deep learning

Si le succès d’estime de ces IA génératrices consacre les modèles de diffusion, l’année du deep learning ne se réduit pas à cette actualité.

L’année a notamment été marquée par la compétition entre les librairies et écosystèmes TensorFlow, développé par Google, et PyTorch projet initié par Facebook/Meta. PyTorch, plus récent, bénéficie d’une dynamique plus ascendante que TensorFlow. Le succès d’HuggingFace, plateforme de mise à disposition de modèles, et où les implémentations PyTorch sont systématiques alors que celles en TensorFlow sont rares a participé à la diffusion de PyTorch.

Preuve du succès de PyTorch, cet écosystème est dissocié de Meta depuis septembre afin de devenir un outil généraliste géré par la Linux Foundation. À l’inverse, Google semble se détacher graduellement de TensorFlow pour privilégier son nouvel écosystème JAX.

Du changement côté RStudio

Depuis quelques années, RStudio a fait le choix de devenir un écosystème de data science généraliste et non plus exclusivement attaché au langage R.

Cette année, cela s’est traduit par la publication, très commentée, de Quarto qui vise à proposer, dans de nombreux langages de programmation, des fonctionalités de publications reproductibles équivalentes à l’un des produits emblématiques de RStudio, à savoir R Markdown. Rien de mieux pour être convaincu de l’intérêt de cet outil que d’observer la galerie d’exemples, d’explorer la documentation très riche, ou de tester soi-même sur un exemple. Cet été, RStudio a également annoncé que Shiny, un autre produit emblématique, serait maintenant disponible sous Python, comme alternative à Dash ou Streamlit.

L’année 2022 a été l’occasion, pour RStudio, d’un autre changement, symbolique celui-ci. Afin de détacher son image du langage R, l’entreprise a en effet changé de nom pour devenir posit. L’entreprise n’a néanmoins pas abandonné son activité foisonnante dans R puisque Hadley Wickham a commencé à publier de nouveaux chapitres pour une nouvelle édition augmentée de l’ouvrage de référence R For Data Science.

Observable devient un incontournable dans le monde de la dataviz

Pour permettre des visualisations interactives, cela fait plusieurs années que JavaScript est un incontournable et que le web assembly retient de plus en plus d’attention.

Les journaux traditionnels utilisent ainsi de plus en plus le data scrollytelling , cette technique de narration qui consiste à présenter des informations sous forme de récit interactif, en utilisant une combinaison de texte et de graphiques qui apparaissent et disparaissent en fonction des actions du lecteur. L’un des exemples les plus réussis des dernières années a sans doute été la visualisation du New York Times “How the virus got out”. Cette approche a également été adoptée par le Ministère de l’Agriculture pour diffuser les chiffrés clés du recensement agricole. Nos voisins anglais ne sont pas en reste puisque les derniers résultats du recensement sont proposés sur un site web remarquable de fluidité.

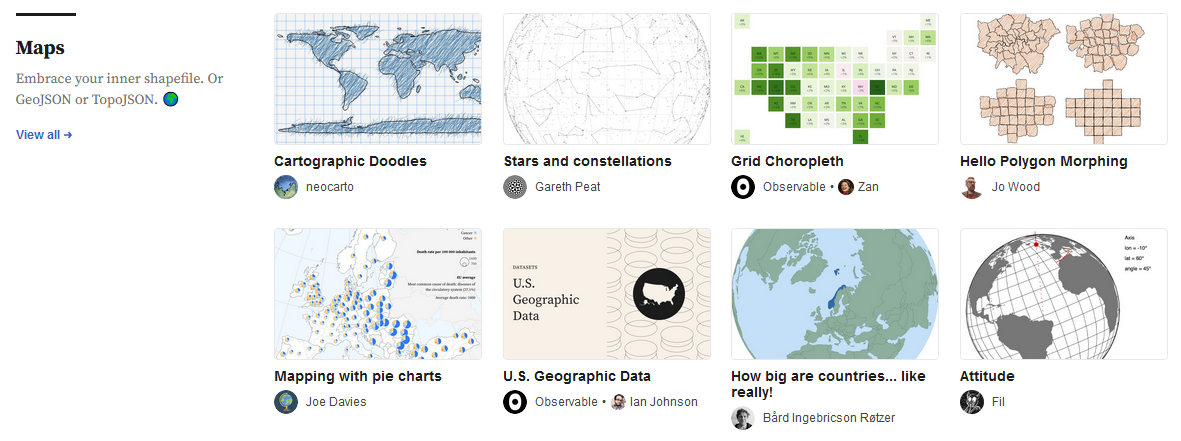

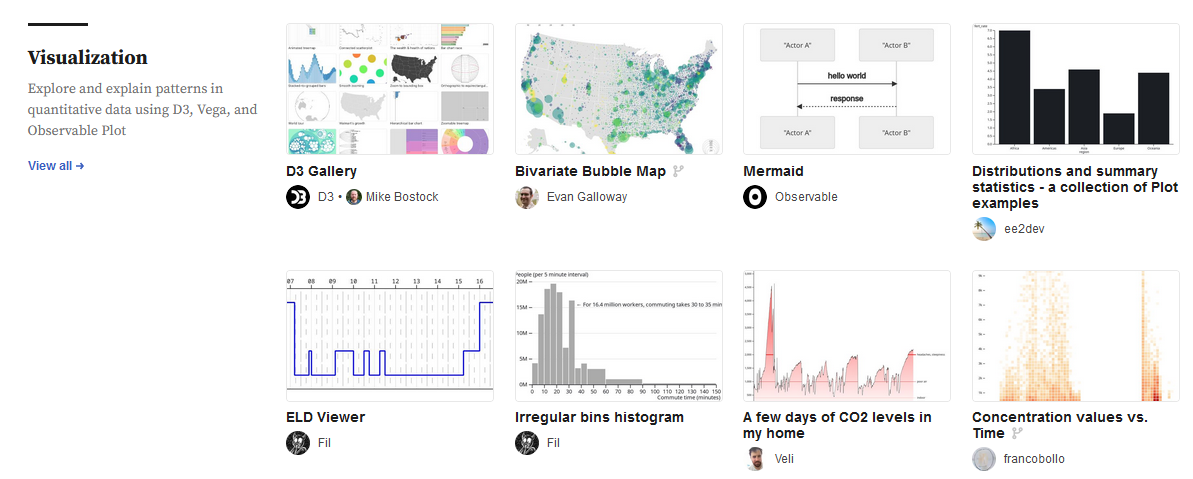

Afin de permettre une diffusion accrue de visualisations en JavaScript, Mike Bostock, déjà créateur de la librairie de dataviz de référence D3.js, est à l’origine de la plateforme observable, sorte de Github de la dataviz permettant du partage et de la réutilisation de notebooks réactifs. En cette année 2022, la plateforme a connu un véritable boom et est devenu un incontournable dans le domaine. L’une des raisons est l’ajout de fonctionalités qui permettent d’étendre le public cible au delà des développeurs web, déjà accoutumés à Javascript. Parmi les fonctionalités les plus remarquables, la possibilité depuis Novembre d’utiliser des requêtes SQL grâce à DuckDB permet aux habitués de R ou de Python de retrouver des manipulations auxquels ils sont habitués. La librairie Plot offre une grammaire proche de ggplot2.

La communauté des cartographes a été particulièrement active sur Observable, notamment à l’occasion du #30daymapchallenge. Nicolas Bertin (neocarto), dont on ne peut que recommander l’introduction à Observable faite pour le réseau, ou Eric Mauvière font partie des comptes à suivre dans la communauté francophone.

Observable, en tant que langage construit sur JavaScript, est également disponible pour les utilisateurs de Quarto, ce qui permet de mettre à disposition des visualisation réactives sans passer nécessairement par la plateforme observablehq.com pour mettre à disposition des visualisations réactives, ce qui constitue une alternative intéressante aux applications qui nécessitent un serveur en arrière plan, comme Shiny ou Dash.

Les autres actualités en France

Le rapport du conseil d’État pour la construction d’une IA de “confiance” a donc été publié en une année 2022 où les avancées techniques des dernières années commencent à être accessibles grâce à des outils plus grand public, ce qui va nécessairement soulever des enjeux éthiques et juridiques.

Le projet Onyxia, qui vise à proposer une infrastructure de data science à l’état de l’art pour data scientists, a organisé son deuxième Openlab. L’occasion de revenir sur le projet, sa philosophie, ses dernières avancées mais aussi d’échanger sur les perspectives de réutilisation dans de multiples environnements et de nouer des partenariats qui permettront au projet de grandir encore en 2023.